يُنشر هذا المقال المترجم بالشراكة مع شبكة قدس الإخباريّة.

نشرت صحيفة "نيويورك تايمز" أواخر العام الماضي تقريراً موسّعاً بعنوان: "داخل دليل قواعد فيسبوك السّريّ فيما يخصّ الخطاب السياسي العالميّ"، للصحافيّ ماكس فيشر. مُستنداً على شهادات موظفين في شركة "فيسبوك"، وعلى أكثر من 1,400 صفحة مُسرّبة من مقرها المركزيّ في مينلو بارك- كاليفورنيا، يُفصّل التقرير آليّة عمل الرقابة في "فيسبوك". يشرح التقرير، الذي ترجم أحمد جمال أجزاءً منه، بأنّ سياسة الموقع تجاه المضامين السياسيّة التي تعتبرها "مضامين تحريض" أو "منشورات كراهية" تتألف من "متاهة" مكوّنة من عشرات "شرائح الـ powerpoint وملفات الـ excel المبعثرة مع عناوين بيروقراطيّة". هذه إحدى الوسائل الهامّة التي تحتكر بواسطتها الشركة قوّةً مهولةً في عصرنا: إنها تحتفظ بحقٍ اعتباطيّ مطلق لقمع التعبيرات السياسيّة، وهو "حق" يخضع لعلاقات المصالح بين الشركة وبين الأنظمة الحاكمة.

مينلو بارك، كاليفورنيا، من داخل غرفة المؤتمرات الزجاجيّة في المقر الرئيس في كاليفورنيا، تقوم فيسبوك بالتعامل مع منشورات الكراهية والمعلومات المغلوطة التي ساعدت على إشعال الأوضاع حول العالم، كلّ منشور على حدة. لقد اتُهمت وسائل التواصل الإجتماعيّ بتقويض الديمقراطية وتأجيج سفك الدماء في المجتمعات الصغيرة والكبيرة على السواء.

لكنّ الأمر يتجاوز ذلك بالنسبة لفيسبوك، فالمسألة تتعلّق بسير العمل المُربِح. كان على الشركة التي تجني أرباحاً ربع سنويّة بقيمة خمسة مليارات دولار أن تُـثبت جديّـتها في إزالة المحتوى الخَطِر، وأن تستمر بجذب مستخدمين جدد من بلدان مختلفة، وأن تحاول إبقاءهم على الموقع لمدة أطول.

كيف تستطيع فيسبوك مراقبة مليارات المنشورات يومياً بأكثر من مئة لغة، دون أن يُؤثر ذلك على عملية التوسع المستمر، والتي تُـشكِّـلُ حجر الأساس لأعمال الشركة؟ يتمثّل الحلّ الذي قدّمته الشركة في خلق شبكة من العاملين يستعملون كمّاً مهولاً ومعقّداً من شرائح الباوربوينت powerpoint لكشف ما هو ممنوع.

صباح كلّ يوم ثلاثاء، يجتمع العشرات من موظفي فيسبوك على الإفطار ليخرجوا بالقواعد ويناقشوا ما الذي يُسمَح لملياري مستخدم على الموقع أن يقولوه. تُرسَـل التوجيهات التي تنتج عن هذا الاجتماعات إلى أكثر من 7500 مشرف حول العالم. (بعد نشر هذا المقال، قالت فيسبوك إنّها زادت هذا العدد إلى 15000).

إنّ هذه القوانين المختارة بدقة ممتدّة على نطاق شامل، مما يجعل الشركة مؤثراً قوياً في الخطاب العالميّ على نحوٍ أكبر بكثير مما تعترف به الشّركة نفسها علناً، وهذا ما كشفته مجلة نيويورك تايمز. حصلت مجلة التايمز على أكثر من 1400 صفحة من القواعد عن طريق موظف صرح بأنه يخشى بأنّ الشركة تمارس سلطةً كبيرةً لا تخضع للإشراف المطلوب، فضلاً عن أنّها ترتكب الكثير من الأخطاء.

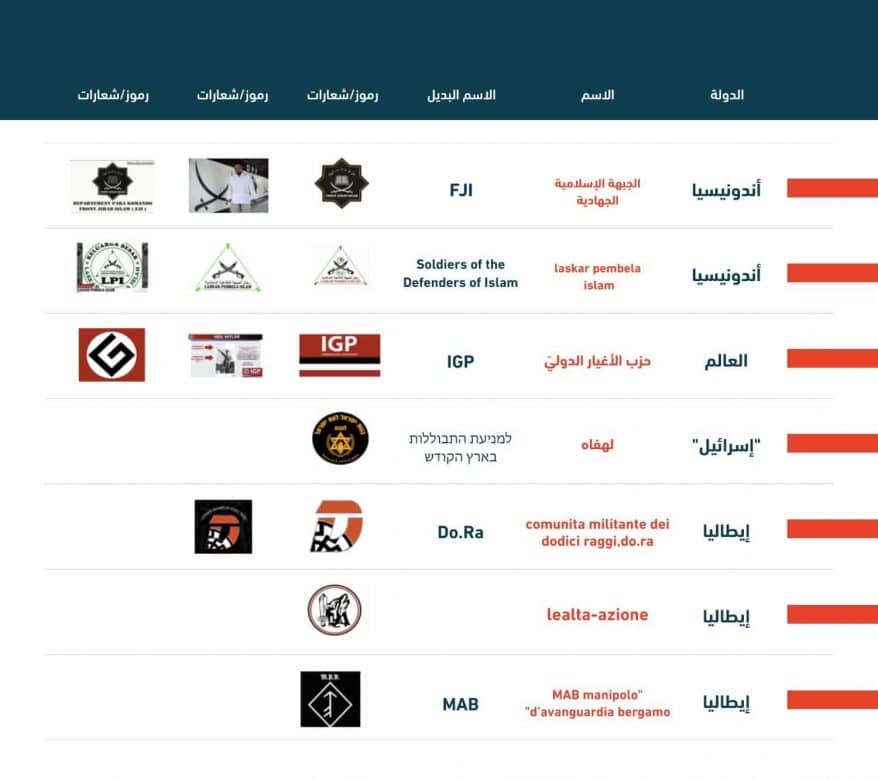

أظهر فحصٌ على هذه الملفات ثغراتٍ وتحيّزاتٍ مهولة، كما أظهر أخطاءً فجّة. وفي الوقت الذي كان يبحث فيه موظفو فيسبوك عن الأجوبة الصحيحة لما يقومون به، فإنهم قد تركوا كثيراً من خطابات المتشددين لتزدهر في بعض البلدان، فيما قاموا بحظر خطابات التيار السائد mainstream في بلدان أخرى.

على سبيل المثال، لا الحصر، طُلب ذات مرة من المشرفين أن يزيلوا حملةً لجمع التبرعات لصالح ضحايا حادثة بركانيّة في إندونيسيا، لأنّ راعياً شريكاً للحملة كان على لائحة فيسبوك الداخليّة للمجموعات المحظورة. في حادثة أخرى في ميانمار، أدى خطأ في سير المعاملات الورقيّة إلى السماح لمجموعة متشددة، مُدانة بتنفيذ إبادات جماعيّة، أن تظلّ نشطة على الموقع لعدة شهور.

عادةً ما يكون موظفو فيسبوك، الذين يجتمعون لوضع التوجيهات، مهندسين ومحامين صغار، يحاولون استخلاص المشاكل المعقدة جداً وتحويلها إلى قواعد نعم-أو-لا بسيطة. ثمّ تستعين فيسبوك بشركات توظّف عدداً ضخماً من الموظفين غير المتخصصين ليقوموا بالإشراف الفعليّ على تطبيق هذه التوجيهات والقواعد على المنشورات، واحدة بواحدة.

لا يمتلك هؤلاء المشرفين، الذين عادة ما يعتمدون على مترجم جوجل Google translate، إلا ثوانٍ معدودة لتذكّر عدد كبير من القواعد وتطبيقها على مئات المنشورات التي تظهر أمامهم على الشاشات كل يوم. متى يكون ذكر كلمة "جهاد" ممنوعاً مثلاً؟ متى يكون استخدام الوجه التعبيريّ "البكاء من الضحك" إشارةً تحذيريّةً؟

يُعـبّـر المشرفون عن استيائهم من بعض القواعد التي يعتبرونها غير منطقية، والتي تتطلّب منهم أحياناً ترك منشورات يشعرون بأنّها قد تؤدي إلى أعمال عنف. "تشعر بأنك تسببت بقتل أحدهم بعدم فعلك شيئاً"، هذا ما قاله الموظّف، الذي فضّل عدم ذكر اسمه لأنه وقع على اتفاق بعدم إفشاء أسرار الشركة.

القواعد

لا تبدو القواعد الإرشاديّة لفيسبوك ككتيب قواعد منظّم لضبط الخطابات السياسيّة العالمية: إنّها تتكون من العشرات من شرائح الـpowerpoint وملفات الـexcel المبعثرة مع عناوين بيروقراطيّة، مثل "منظمات ورموز نشر الكراهية في غرب البلقان"، و"عنف معتبر: معايير التنفيذ".

ولأنّ فيسبوك قد انجرّ إلى هذه المنهجية عن طريق الصدفة إلى درجة ما، فإنّه لا يمتلك ملفاً رئيسياً أو دليلاً شاملاً للعمل، بل مجرد خليط من القواعد التي وضعتها أقسامٌ مختلفةٌ من الشركة. حصلنا من فيسبوك على تأكيد بموثوقية المستندات رغم أنّهم قالوا بأن بعضها قد جرى تحديثه منذ أن حصلت عليها مجلة التايمز.

يبدو هدف الشركة طموحاً: تقليل الأسئلة المرتبطة ارتباطاً وثيقاً بسياقها، والتي تشكّل معاناة حتى للخبراء القانونيّين، مثل: متى تكون الفكرة دافعة للكراهية؟، متى تكون الإشاعات خطرة؟، إلى معيار واحد يلائم جميع القواعد. تسعى فيسبوك إلى منع التحيز وفرض الاتساق من خلال إخبار المشرفين باتباع الأوامر بطريقة عمياء.

تقول فيسبوك بأنّ الملفات تستخدم فقط للتدريب، لكنّ المشرفين يقولون بأنّها تستعمل كمواد مرجعيّة يومية. قد تبدو القواعد منطقيّة إذا أخذتَ كل واحدة على حدة، ولكنّها معاً ستغدو أشبه بمتاهة مُحيّرة. تُحدّد إحدى هذه الملفّات جملة من القواعد التي تقرّر ما إذا كانت كلمة مثل "شهيد" أو "جهاد" إشارةً لخطابٍ إرهابيٍّ أم لا. ويُخصّص ملفٌّ آخر قواعد لتحديد متى يجب منع النقاش حول مجموعة محظورة. كذلك قد تصبح كلمات مثل "أخ" أو "رفيق" ممنوعة في سياق معين، إلخ.

شكّلت عملية تعريف خطابات الكراهية مشكلةً مُربِكةً لفيسبوك، فعلى المشرف، بعد المرور على 200 صفحة مليئة بالمصطلحات المثيرة للدوار أن يقوم بتصنيف المنشور إلى واحدة من ثلاثة مستويات من الخطورة. وعليه أن يأخذ بعين الاعتبار قوائم عدّة مثل: "المقارنات الستة المنتهكة للإنسانية"، إحدى هذه المقارنات هي مقارنة اليهود بالجرذان.

"هناك توتّر حقيقيّ هنا بين الحاجة إلى قواعد دقيقة قادرة على التعامل مع كلّ حالة، وبين الحاجة إلى مجموعة من السّياسات التي نستطيع تنفيذها بدقة ونستطيع شرحها بوضوح"، تقول السيدة بيكرت، المديرة التنفيذية في فيسبوك.

فرع غير مرئي للحكومة

رغم أن التوجيهات مُفصّلَة بقدر المستطاع، إلا أنه توجد كذلك بعض التقريبات والتخمينات حول أفضل السبل لمواجهة التشدد ونشر المعلومات المغلوطة. وكثيراً ما يؤدّي ذلك بدوره إلى جعل فيسبوك يتدخل في أمور سياسيّة حساسة على مستوى العالم، وأحياناً يكون هذا التدخل غير مبنيٍّ على فهم جيّد.

في شهر يونيو/ حزيران [2018]، وبناء على رسائل إلكترونيّة داخلية، قامت المجلة بمراجعتها، طُلب من المشرفين أن يسمحوا للمستخدمين بالإشادة بطالبان -وهي في العادة مجموعة محظورة- إذا ما أشاروا إلى قرار المجموعة الالتزام بوقف إطلاق النّار. في رسالة إلكترونيّة أخرى، طُلِب من المشرفين أن يُلاحقوا ويُزيلوا إشاعةً تتهم خطأ جنديّاً إسرائيليّاً بقتل مسعفةٍ فلسطينيّةٍ.

تقول جاسمن موجانوفيتش، وهي خبيرة في شؤون البلقان، بأنّ "دور فيسبوك أصبح مُهيمناً واحتكارياً بدرجةٍ كبيرةٍ حتى أنّه قد أصبح قوّةً بحدِّ ذاته"، وتتابع القول: "لا يحقّ لأيّ كيانٍ -وخصوصاً لشركة ربحيّة مثل فيسبوك- أن تمتلك هذا النوع من القوّة في التأثير على القضايا والسياسات العامة".

في باكستان، وقبل الانتخابات التي عقدت في شهر يوليو/ تموز [2018] بوقت قليل، وزّعت فيسبوك على المشرفين ملفاً من 40 صفحة بعنوان "الأحزاب السياسيّة، اتجاهات مُحتَملة وتوجيهات". في باكستان، وهي إحدى أكبر وأكثر الديمقراطيات هشاشةً، يُفرضُ صمتٌ انتخابيٌّ عشيّة الانتخابات، في الوقت الذي يصبح فيسبوك ميداناً للنقاشات والأخبار أثناء التصويت.

قام الملف المذكور بتشكيل هذه النقاشات إلى درجةٍ كبيرة، وإن لم يكن لدى الباكستانيين أنفسهم ما يجعلهم يعرفون ذلك. في إحدى الحالات، طُلب من المشرفين أن يقوموا بتدقيقٍ إضافيٍّ على منشورات "جمعية علماء الإسلام"، وهي حزب دينيّ متشدد؛ بينما تمّ وصف حزب دينيّ آخر وهو الجماعة الإسلاميّة بأنه "غير خطر".

المشهد من مينلو بارك

قد يتمّ إعداد سياسات فيسبوك في غرف المؤتمرات المجهّزة جيداً. لكن تنفيذها يتمّ على يد المشرفين في مكاتب الشّركات الباهتة التي تستعين بها "فيسبوك" في مناطق بعيدة مثل المغرب والفلبين. يقول فيسبوك بأنّ المشرفين يمتلكون وقتاً كافياً لمراجعة المنشورات، ولكنّ المشرفين يؤكّدون أنّهم يواجهون ضغطاً صعباً عند مراجعة آلاف الأجزاء من المحتوى الموجود يومياً. فليس لديهم إلا 8 إلى 10 ثواني لكلّ منشور، ومدة أطول بقليل للفيديوهات.

يصف المشرفون العاصفة التي تدور في رؤوسهم. عند البعض، يرتبط الحصول على المرتّب بالسرعة والدقة. ينهار الكثيرون بعد بضعة أشهر متعبة. ليس لدى المشرفين على الخطّ الأمامي إلا أدوات قليلة لتنبيه فيسبوك للتهديدات الجديدة والثغرات الماثلة في القواعد، دون ما يكفي من الحوافز لفعل ذلك، على حدّ وصف أحدهم.

يقول أحد المشرفين بأنّ القاعدة العامة للمراكز هي قبول أي منشور إنْ لم يتوفّر من يستطيع قراءة اللغة في حينه. لربما ساهم ذلك في أعمال العنف في سريلانكا وميانمار، حيث كانت المنشورات التي تشجّع على التطهير العرقي تبقى بشكل روتيني على فيسبوك.

يقول فيسبوك بأن أي ممارسات كهذه تنتهك قواعده، التي تنصّ في حالات الطوارئ على مراجعة المنشورات المكتوبة بلغة غير مفهومة. يقول جاستن أوسوفسكي، نائب رئيس فيسبوك المشرف على هذه العقود، بأن أي تجاوزات قد يكون سببها المدراءُ العاديون في الشركات الخارجيّة التي تتصرف من تلقاء نفسها.

يشير هذا إلى مشكلة أعمق وهي أن لدى فيسبوك رؤية ضعيفة للشركات الضخمة التي تستعين بها، والتي عادة ما تضع سياساتها بنفسها، والتي قد عانت أحياناً من إدارتهم. ولأن فيسبوك تعتمد على الشركات لدعم تمددها فإن سلطتها عليهم محدودة.

قد تكون العقبة التي تحول دون إيقاف الخطاب التحريضيّ على فيسبوك هي خوارزميّة فيسبوك نفسه. فالمنصة تعتمد على خوارزمية تميل لترويج أغلب المحتوى الاستفزازي، وكثيراً ما يكون هذا المحتوى هو نفسه الذي تقول فيسبوك إنّها تريد منعه.

تستطيع فيسبوك أن تخفّف حدّة هذه الخوارزمية، أو تقلل من توسّعها في الأسواق التي ثبت بأنّ دور فيسبوك فيها هدّام ومؤذٍ. لكن شبكات التواصل الإجتماعي ترسخ في موظفيها إيماناً لا شك فيه بأن منتجاتهم هي قوّة للخير. عندما سئلت الأنسة سو -وهي مهندسة مسؤولة عن تغذية المحتوى- عن رأيها ببحث خَلُص إلى أن استخدام فيسبوك مرتبط بتزايد العنف، ردت قائلة: "لا أعتقد ذلك". وقالت إنّه "كلما كان لدينا وصول أكبر وكلما اتسع نطاق الناس المنخرطين، كلّما تزايدت المخاطر". ولكنها تعتقد أن ذلك يجلب معه فرصة أكبر لتعرّض الناس لأفكار جديدة.

مع ذلك فإن بعض المدراء التنفيذيين يترددون عندما يُسألون عما إذا كانت الشركة قد وجدت التركيبة الصحيحة فعلاً. يقول ريتشارد ألان، وهو نائب رئيس يعمل من لندن، وهو أيضاً عضو في مجلس اللوردات، بأنّه من الممكن الوصول إلى نموذج أفضل من خلال "بعض اتفاقيات الشراكة" مع "تدخل الحكومات في وضع القواعد"، رغم أن كثيراً من الحكومات لا يمكن الوثوق بها مع كل هذه القوة.

فيما قال السيد فيشمان، الخبير بشؤون الإرهاب، إن على الشركة أن تأخذ بعين الاعتبار إمكانيّة ترك مساحة أوسع لاتخاذ القرارات من قبل المشرفين، الذين قد يفهمون بشكل أفضل المسائل الدقيقة في الثقافة والسياسة المحليّة. مع ذلك، وفي مركز الشركة الرئيس، تبقى أكثر الأسئلة الأساسية غير مجابة: أي نوع من المحتوى يؤدي بشكلٍ مباشرٍ إلى العنف؟ ومتى تؤدي المنصة إلى تفاقم التوتر الإجتماعي؟ تقول روزا بيرتش، التي تقود فريق الأزمة الداخلي، بأنّها هي وزملاؤها قد طرحوا هذه الأسئلة لسنوات عديدة، وأنهم يحرزون تقدماً، ولكن دون أن يصلوا إلى إجابات مؤكدة.

من دون فهم كامل لتأثير المنصة، فإنّ هذه السياسات ستظلّ استجاباتٍ مُخصصة لمواجهة المشاكل بعد ظهورها. يُجري الموظفون بعضَ التعديلات التجريبية، ثم ينتظرون ليروا ماذا سيحدث، ثمّ يقومون بتعديلاتٍ تجريبيّة أخرى، وكأنّهم يقومون بإصلاح الطائرة في منتصف الرحلة.

"إنّ أحد أسباب صعوبة التحدث عن ذلك، هو نقص التوافق المجتمعي حول أين يجب أن تقع هذه السلطة"، هكذا قال السيد فيشمان. ولكنه قال إنّه من الصعب إيجاد حلِّ آخر!

بينما يحدث ذلك، تواصل الشركة توّسعها للوصول إلى أكبر عدد من المستخدمين في بلدان أكثر.